Cada día en el mundo los usuarios ven más de mil millones de horas de videos de manera conjunta. Detrás de estos números hay algoritmos que se encargan de personalizar listas de videos y publicaciones a partir de los hábitos y gustos de los usuarios en la plataforma.

Según recoge The Wall Street Journal, YouTube ha dicho que estas recomendaciones ocupan más del 70 % del tiempo de visualización, lo que hace entender entonces, que el algoritmo es el que decide por encima del mismo usuario.

Por esa razón, una investigación del mismo medio encontró que en muchos casos las recomendaciones pueden ser un poco ‘oscuras’. En ese sentido, descubrieron que la plataforma lleva a los visitantes por videos y canales sobre temas como teorías de conspiración, puntos de vista parcializados, desinformación y más, incluso, cuando nunca se ha demostrado ningún tipo de interés por estos temas.

También te puede interesar

Sin duda, esto pone en evidencia cómo las redes sociales y sitios similares pueden amplificar mensajes extremistas o la desinformación, construyendo así ideas o conceptos en las personas. La plataforma recomienda más de 200 millones de videos al día en más de 80 idiomas y señala que constantemente está mejorando el algoritmo para que el contenido sea más ‘autorizado’, disminuyendo de esa manera el impacto de material sospechoso.

Sin embargo, explica que el algoritmo sufre problemas por ejemplo con temas políticos porque “funciona de la misma manera para las personas que vienen a buscar videos de gatos o de costura o lo que sea”.

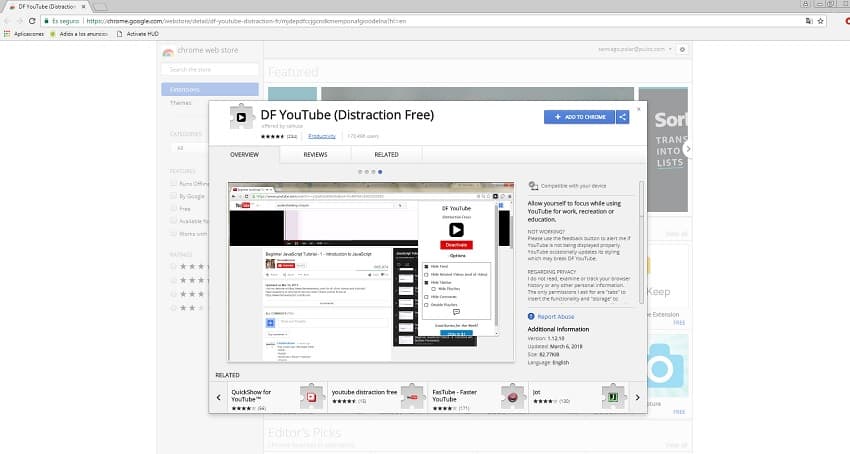

Ahora, como explica Gizmodo, hay una forma de desactivarlos en Chrome a través de una extensión que se llama “Distraction Free YouTube”. De esta herramienta se despliega un menú que permite bloquear recomendados de la columna de la derecha o de la página principal, también puede bloquear comentarios y hasta listas de reproducción.

LO ÚLTIMO

.svg)